AI Trust Center van GoTo

Laatst gewijzigd op 3 maart 2025

Inleiding

GoTo biedt klanten hulpmiddelen om hun productiviteit en efficiëntie te verhogen, door met kunstmatige intelligentie (AI) aangedreven diensten te integreren in de producten voor bedrijfscommunicatie, samenwerking, ondersteuning op afstand en IT-beheer (de 'GoTo-services').

We gebruiken Large Language Models (LLM's) en toonaangevende AI-modellen om een groeiend aantal toepassingen in onze GoTo Services te kunnen ondersteunen. Voorbeelden zijn interactieve op AI-gebaseerde assistenten, geautomatiseerde suggesties voor het oplossen van IT-problemen, en functionaliteit om IT-managementscripts te genereren en te analyseren, vergaderingen en gesprekken samen te vatten, en operationele bedrijfsinzichten te bieden.

Hoewel AI aanzienlijke voordelen biedt, is het ook een snel evoluerende technologie met potentiële risico's. Op deze pagina leggen we uit hoe GoTo in de praktijk omgaat met de beheersing van deze risico's, en de klant ondersteuning biedt om alle voordelen te benutten van de op AI-gebaseerde functionaliteit.

Privacy en beveiliging staan voorop wanneer GoTo een AI-functie ontwerpt. Ga voor meer informatie over het privacy- en beveiligingsbeleid van GoTo naar ons Trust Center.

Verantwoord gebruik van AI bij GoTo

GoTo legt zich toe op het verantwoord inzetten van kunstmatige intelligentie om zowel de efficiëntie als de bescherming van producten te verbeteren, en onethische of anderszins schadelijke resultaten te voorkomen. De op AI-gebaseerde productfuncties zijn ontworpen met de volgende onderliggende principes voor verantwoord gebruik van AI:

- Eerlijkheid. Bescherming tegen bevooroordeelde of discriminerende uitvoer, inclusief het minimaliseren van het gebruik van gegevensinvoer die kan leiden tot discriminerend modelgedrag.

- Transparantie. Klanten en eindgebruikers weten dat ze met AI werken en op AI gebaseerde functies gebruiken. GoTo legt uit hoe en waar AI in producten is verwerkt en hoe het precies werkt.

- Verantwoordingsplicht. Er zijn controle- en auditmechanismen geïmplementeerd om onverwachte of schadelijke uitvoer te kunnen identificeren. Functies worden vanaf de basis ontworpen om menselijk toezicht en controle mogelijk te maken, in een mate die passend is voor de risico's en de aard van de betreffende AI-functie.

- Privacy en veiligheid. GoTo implementeert robuuste systeemontwerpen met regelmatige tests en monitoring ter bescherming van gegevens. Privacy ligt aan de basis van de inrichting van AI-functies, die ontworpen zijn om alleen de minimale hoeveelheid gegevens te verwerken die nodig is om de betreffende functie goed te laten werken.

- Ethisch gebruik. AI wordt uitsluitend gebruikt voor positieve, en nooit voor schadelijke doeleinden. Er zijn controlemechanismes ingericht ter bescherming tegen AI-hallucinaties, verkeerde informatie, onnauwkeurigheden, mensenrechtenschendingen en andere mogelijk schadelijke output.

Leidend principe: Ons AI-vertrouwensmodel

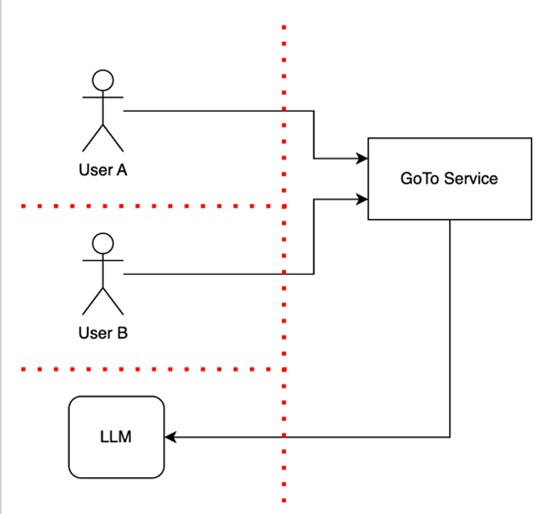

Bij het ontwerpen van AI-functies implementeert GoTo vertrouwensbarrières om de gegevens van gebruikers zowel van elkaar als van de productinfrastructuur te scheiden. Het principe van dit vertrouwensmodel is dat een vertrouwde infrastructuur geen mensen of AI-modellen van dezelfde vertrouwensenclave mag opnemen, zoals gedemonstreerd in het onderstaande diagram.

Het diagram toont twee gebruikers, Gebruiker A en Gebruiker B, die een GoTo-service gebruiken die een op LLM gebaseerde functie bevat, aangegeven door de pijl naar de betreffende LLM. De rode lijn vertegenwoordigt de beveiligde vertrouwensbarrières die de gevoelige informatie en functionaliteit beschermen, en gebruikers zowel van elkaar scheiden als van de productinfrastructuur, inclusief de LLM. In deze vertrouwensbarrières kunnen controlemechanismen worden geïmplementeerd (zoals verificatie, autorisatie en sanity checks) wanneer controle- of gegevensstromen deze barrières kruisen.

Zoals dit diagram laat zien, heeft Gebruiker B geen toegang tot gegevens of apparaten van Gebruiker A.

Dit vertrouwensmodel beschermt de klantgegevens tegen ongeautoriseerde toegang en ongeautoriseerd gebruik, en beschermt GoTo's diensten tegen aanvallen of kwetsbaarheden.

Vrijwaringsmechanismen

Bij het ontwerpen van LLM-toepassingen of op LLM gebaseerde functies blijft GoTo op de hoogte van LLM-specifieke en andere AI-gerelateerde risico's, zoals prompt injection, vergiftiging van trainingsgegevens, en kwetsbaarheden in de toeleveringsketen, en implementeert vervolgens beveiligingsmaatregelen om deze aan te pakken. Met GoTo's vertrouwensmodel en toezicht op algemene AI-gerelateerde risico's als uitgangspunt, gebruiken we meerdere hieronder beschreven mechanismen, zoals het 'human in control'-principe een multi-tenantarchitectuur, waarmee gebruikers optimaal kunnen profiteren van AI-toepassingen en -functies op een manier die eveneens de gegevensbeveiliging bevordert.

Hoewel AI-modellen waardevolle mechanismen bieden om taken te automatiseren, antwoorden op vragen te genereren, en hoogwaardige output te produceren, moeten gebruikers zich ervan bewust zijn dat deze modellen verschillen van traditionele softwareservices doordat ze ook onjuiste antwoorden of onbedoelde output kunnen produceren. Als u AI-toepassingen gebruikt, moet het vertrouwen dat u stelt in outputs van AI-modellen (inclusief LLM's) daarom vergelijkbaar zijn met uw niveau van vertrouwen in outputs die door andere gebruikers zijn gemaakt. Daarom raden wij aan: Vertrouw, maar verifieer. U moet altijd de volledigheid en nauwkeurigheid nagaan van AI-uitvoer als antwoord op uw gebruikersvragen.

Met die vuistregel in gedachten worden de volgende beveiligingsmechanismen waar nodig geïmplementeerd als AI in GoTo-services is opgenomen:

- 'Human in control'-principe AI-functies zijn zo ingericht dat een menselijke gebruiker het laatste woord heeft over of en hoe de uitvoer die door een AI-model (zoals een LLM) wordt gegenereerd, mag worden gebruikt. De gebruikers die producten gebruiken behouden zo de controle, en dienen expliciete goedkeuring te geven voor gevoelige handelingen.

- Multi-tenantarchitectuur met LLM. GoTo zorgt ervoor dat individuele gebruikers aparte sessies (gesprekken) hebben met de LLM-service, die niet toegankelijk zijn voor andere gebruikers. Dit betekent dat overige gebruikers geen toegang kunnen krijgen tot gevoelige informatie die per ongeluk in een prompt wordt gedeeld.

- Klantgegevens worden nooit gebruikt door derden voor het trainen van hun LLM-service. Bij het aanbieden van AI-functies via een externe aanbieder, is het externe aanbieder niet toegestaan om de gegevens van GoTo-klanten te gebruiken voor trainingsdoeleinden.

- Validatie van invoer en uitvoer. GoTo's diensten valideren de indeling van de invoer met behulp van gebruikelijke validatietechnieken, waaronder reguliere expressies en parsers. Onze services weigeren bepaalde soorten onverwachte invoer en uitvoer op basis van validatieresultaten om beveiligingsrisico's te beperken, gegevensverlies of -corruptie te voorkomen, en fouten tot een minimum te beperken. Wij valideren bijvoorbeeld op onverwachte invoer en uitvoer die tekstinjecties, irrelevante prompts, beschadigde gegevens of onverwachte foutgevallen lijken te zijn.

Transparantie: Gebruik van AI-functies

We streven ernaar om functies in GoTo Services die AI-aangedreven zijn, duidelijk als zodanig te identificeren. We lichtten bijvoorbeeld functies uit die AI tekstueel gebruiken, of duiden AI-functionaliteit aan met een glinsterend pictogram, zoals hieronder weergegeven. Onze klanten kunnen zo zelf kiezen of ze de functie of de uitvoer ervan willen gebruiken. Eventueel kunnen klanten of gebruikers ervoor kiezen om AI-functies die ze niet willen gebruiken uit te schakelen. Raadpleeg de productspecifieke ondersteuningspagina's voor meer informatie.

Voorbeelden van identificatie van AI-functies:

Transparantie: Gebruik van gegevens

In sommige gevallen, en alleen als klanten daarvoor toestemming geven, kan GoTo klantgegevens gebruiken om de AI-modellen van GoTo te trainen om de algehele uitvoerkwaliteit van een product te verbeteren. Voor klanten die ervoor kiezen om dit gegevensgebruik toe te staan, treft GoTo maatregelen om alleen de benodigde informatie te verwerken en LLM-verzoeken te beperken tot essentiële contextuele details, zoals verder uiteengezet in het gedeelte 'Gegevensminimalisatie'. Zie voor een voorbeeld van deze aanpak de veelgestelde vragen over het Gebruik van Gebruikerscontent in LogMeIn Resolve.

Meer informatie over het gebruik van AI-functionaliteit in GoTo-producten kunt u vinden in de AI-voorwaarden van GoTo, die van toepassing zijn op het gebruik van deze functionaliteit door klanten.

Gegevensminimalisatie:

GoTo streeft ernaar LLM-verzoeken te beperken tot essentiële contextuele details. Als een klant bijvoorbeeld contextuele details wil opnemen in een invoer voor een LLM om de nauwkeurigheid te verbeteren, proberen GoTo-services alleen informatie te gebruiken die relevant is in die context, met behulp van de zogenaamde RAG-techniek (Retrieval Augmented Generation). Dit betekent dat wanneer we bijvoorbeeld een diagnose stellen van een apparaat in LogMeIn Resolve of LogMeIn Rescue, we wel de apparaatgegevens opnemen, zoals gegevens over CPU-gebruik en geheugen, maar niet de persoonlijke gegevens over de gebruikers van het apparaat.

Principes van Minste privilege en Functie-gebaseerd risico

Bij het ontwerpen van de GoTo-services, inclusief de AI-gebaseerde functies, houden we rekening met de risico's van die specifieke functie en het principe van de 'minste privileges', wat betekent dat een AI-service alleen toegang heeft tot de specifieke gegevens of bronnen die nodig zijn voor die specifieke functie. Dat wil zeggen dat de toegang tot gegevens technisch wordt beperkt, bijvoorbeeld door technische rollen met beperkte toegangsrechten te gebruiken.

Voordat we besluiten om een AI-functie te implementeren, nemen we risico's op basis van die functie in overweging. Om de toegang op de juiste manier te beperken, beperken we de rechten en gegevens waartoe een AI-service toegang heeft tot alleen datgene wat nodig is om de functie goed te laten werken.